Szukamy łowców meteorytów

„Łowcy mikrometeorytów” to program edukacyjny dla dzieci i młodzieży ze szkół podstawowych (7 i 8 klasa) oraz średnich. Jego celem jest pozwolić Wam, uczniom i nauczycielom, odnaleźć w…

Nowości w NTL

Jak energetyki wpływają na młodzież?

Życie w świetle i ciemności, czyli czemu jedni śpią w nocy, a inni w dzień

Jak działa człowiek?

Nowoczesne technologie

Początek chatu GPT. Czy maszyny mogą myśleć i czy można je odróżnić od człowieka?

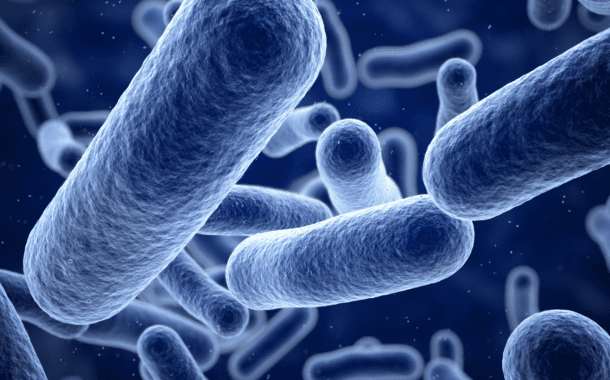

Biodruk 3D: Bioniczna trzustka szansą dla tysięcy chorych. Polacy pracują nad rewolucją

Poza Ziemią

Kosmiczna liczba Pi. Jak marcowa solenizantka pomaga nam zdobyć Układ Słoneczny?

Misja Artemis

Misja Artemis 1: Ostatni rozdział, czyli powrót do domu

Misja Artemis 1 wstępnie miała się rozpocząć pod koniec sierpnia. Ostatecznie rakietę wystrzelono 16 listopada. Dziś, po 25 dniach, kończy się lot maszyny w przestrzeni kosmicznej. W…

#polscysuperbohaterowie

Rękawica tłumacząca język migowy ułatwi komunikację z osobami niemymi

Benedykt Dybowski – wielki podróżnik i odkrywca Syberii

Nauka. To Lubię na Pyrkonie 2022 – czy znasz polskich naukowców?

Polska stacja antarktyczna Arctowskiego – co o niej wiesz?

9 faktów z życia Kopernika, o których mogłeś nie wiedzieć

Filmy

Jak zmienić polską edukację?

Czy nasz system edukacji wymaga jakiejkolwiek reformy? -Jeżeli wyeliminujemy oceny i sprawdziany, musimy pogodzić się z faktem, że pewna ilość ludzi będzie kończyła szkoły jako analfabeci…

Jak energetyki wpływają na młodzież?

Czarne chmury przed polskim atomem

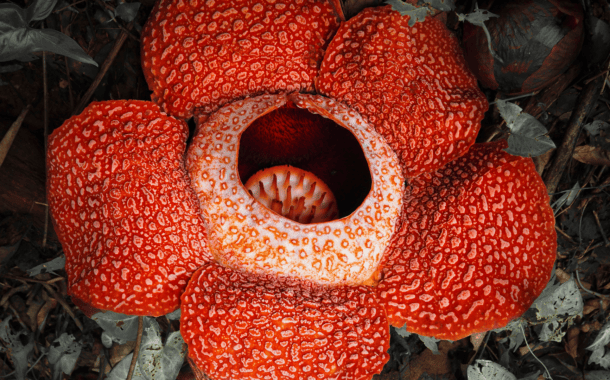

Nie taki słodki kotek

Cudowny lek czy żart Elona Muska?

Rocket Jobs – Zawód: inżynier

Podcasty NTL

Nowości w NTL Junior

Życie w świetle i ciemności, czyli czemu jedni śpią w nocy, a inni w dzień

Nowości w Akademia Cyfrowego Rodzica

Gry online dają więcej niż tylko rozrywkę. Czy warto je wpisać do CV?

Krótkowzroczność to nie wyrok – wywiad z optometrystką Sylwią Kijewską

„Akademia Superbohaterów”

Polscy naukowcy zmienili i zmieniają naszą rzeczywistość. Dlaczego jednak tak mało ludzi w Polsce i na świecie wie o ich osiągnięciach? Chcemy to zmienić, dlatego kilka miesięcy temu powstał projekt, który Tomasz Rożek nazwał „Akademią Polskich Superbohaterów”. To przestrzeń, w której będziemy opowiadać o życiorysach tych niezwykłych postaci. W ramach projektu powstała pierwsza gra karciana autorstwa Tomasza Rożka oraz książka pt. „Akademia Superbohaterów”, gdzie w roli głównej występują najwybitniejsi polscy naukowcy.

![Misja Artemis 1 – transmisja on-line [update]](https://naukatolubie.pl/app/uploads/2022/08/Artemis-on-line-380x300.png)